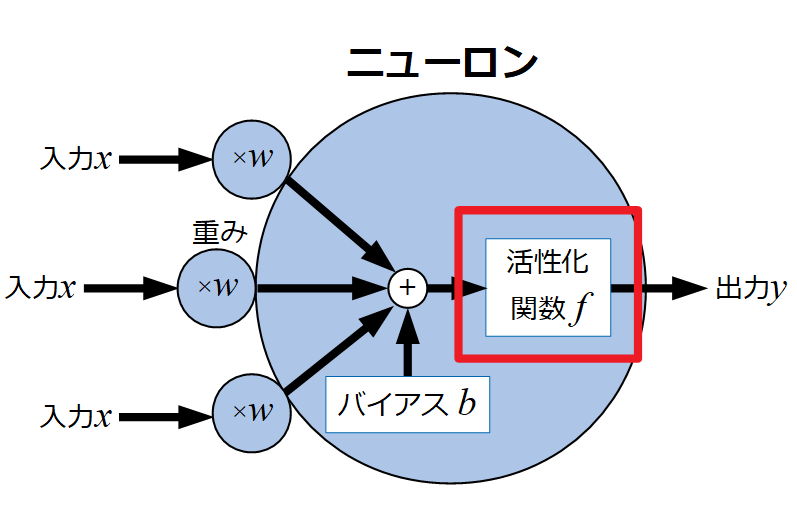

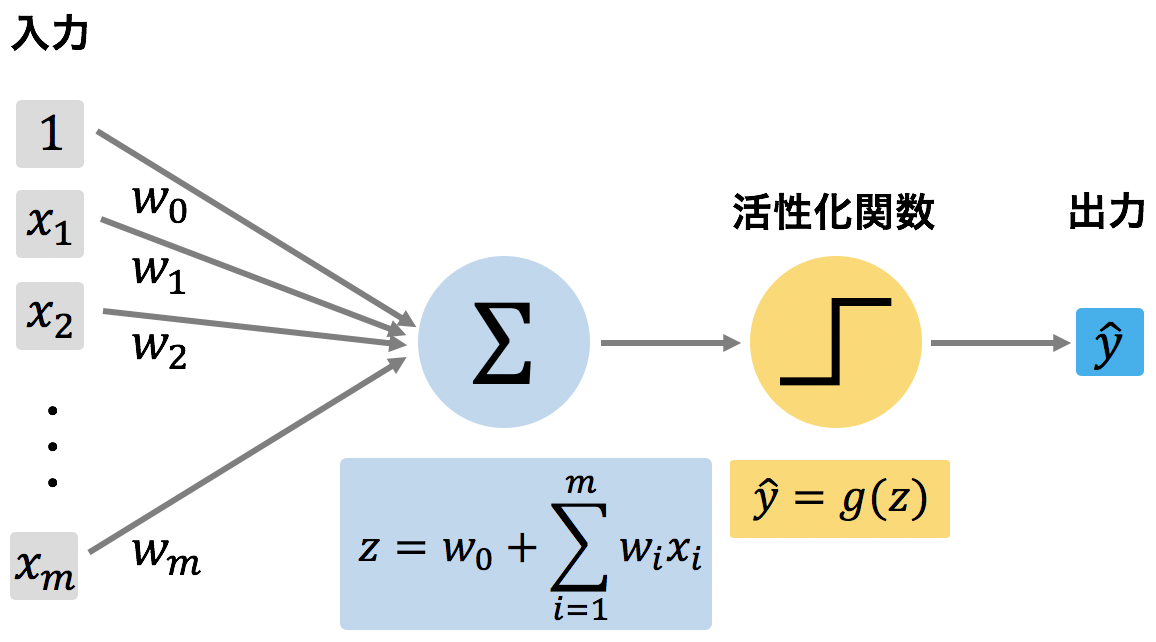

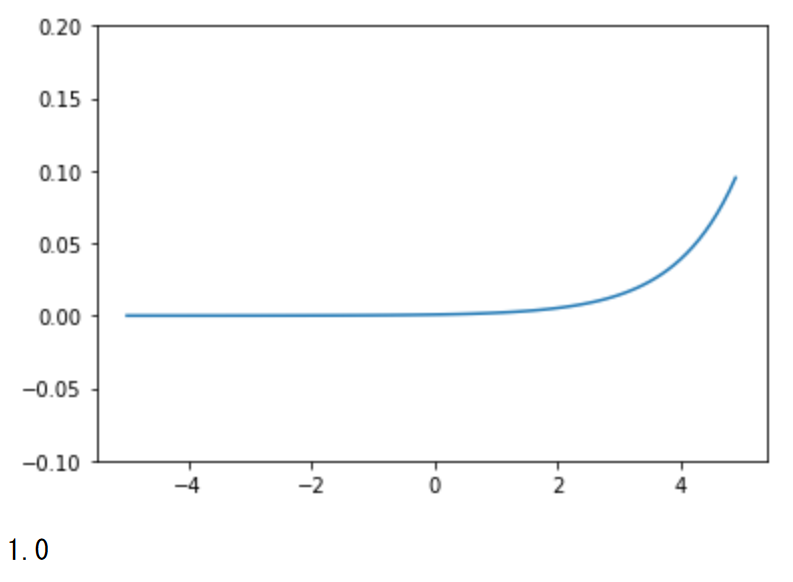

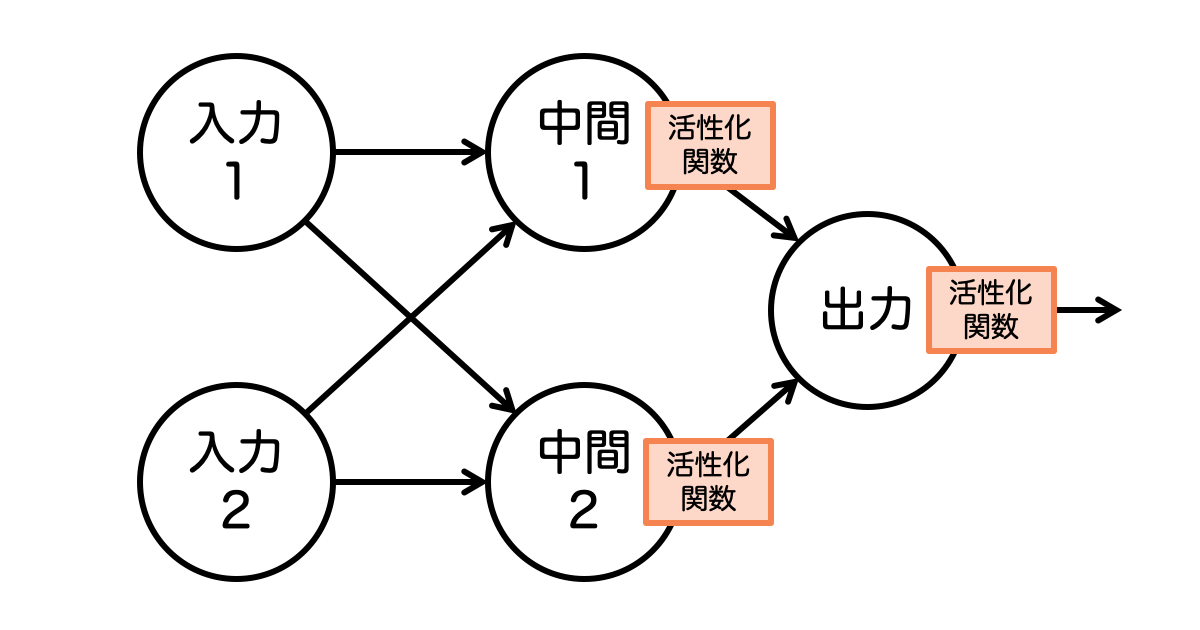

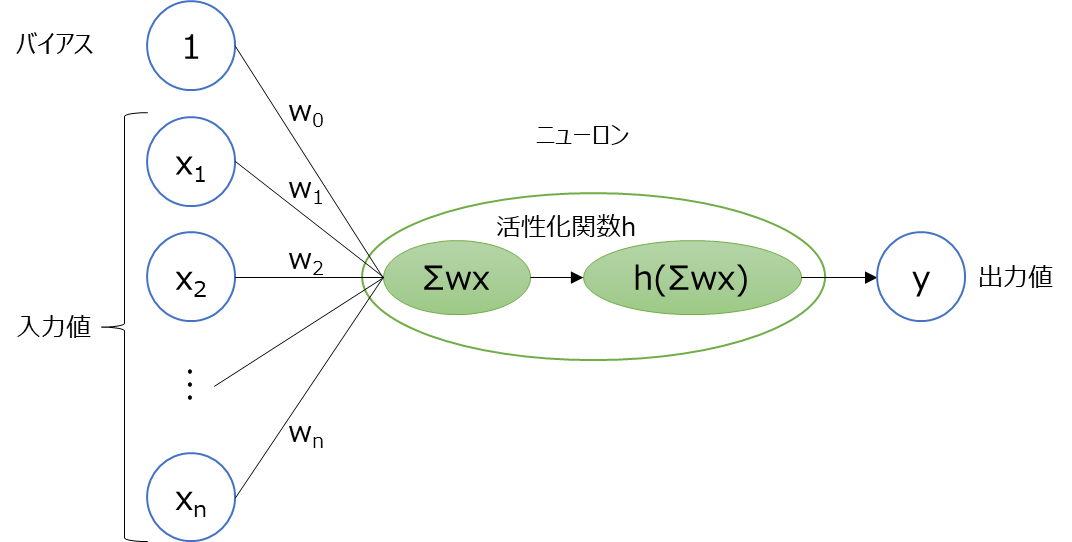

活性化関数は、ニューロンへの入力を出力に変換する際に、非線形な変換を行うことで、ニューラルネットワークの表現力を高めます。. 活性化関数がなければ、ニューラルネットワークは単なる線形変換の積み重ねになってしまい、複雑な問題に対応でき.. ニューラルネットワークにおいてインプットに特定の関数をかませて変換してアウトプットする関数を活性化関数と呼びます。 活性化関数に利用される関数はいくつかあるのですが、その中でもよく使われるのがReLU(Rectified Linear Unit)関数なのです。

Kerasを使って活性関数・目的関数・最適化手法をまとめる(ディープラーニング)

ニューラルネットワークとは何か? インダス株式会社のブログ

ニューラルネットワークの基礎 — ディープラーニング入門:Chainer チュートリアル

ニューラルネットワーク なぜDEEPにするのか?(非線形関数と線形関数) Qiita

ニューラルネットワークに活性化関数がある理由

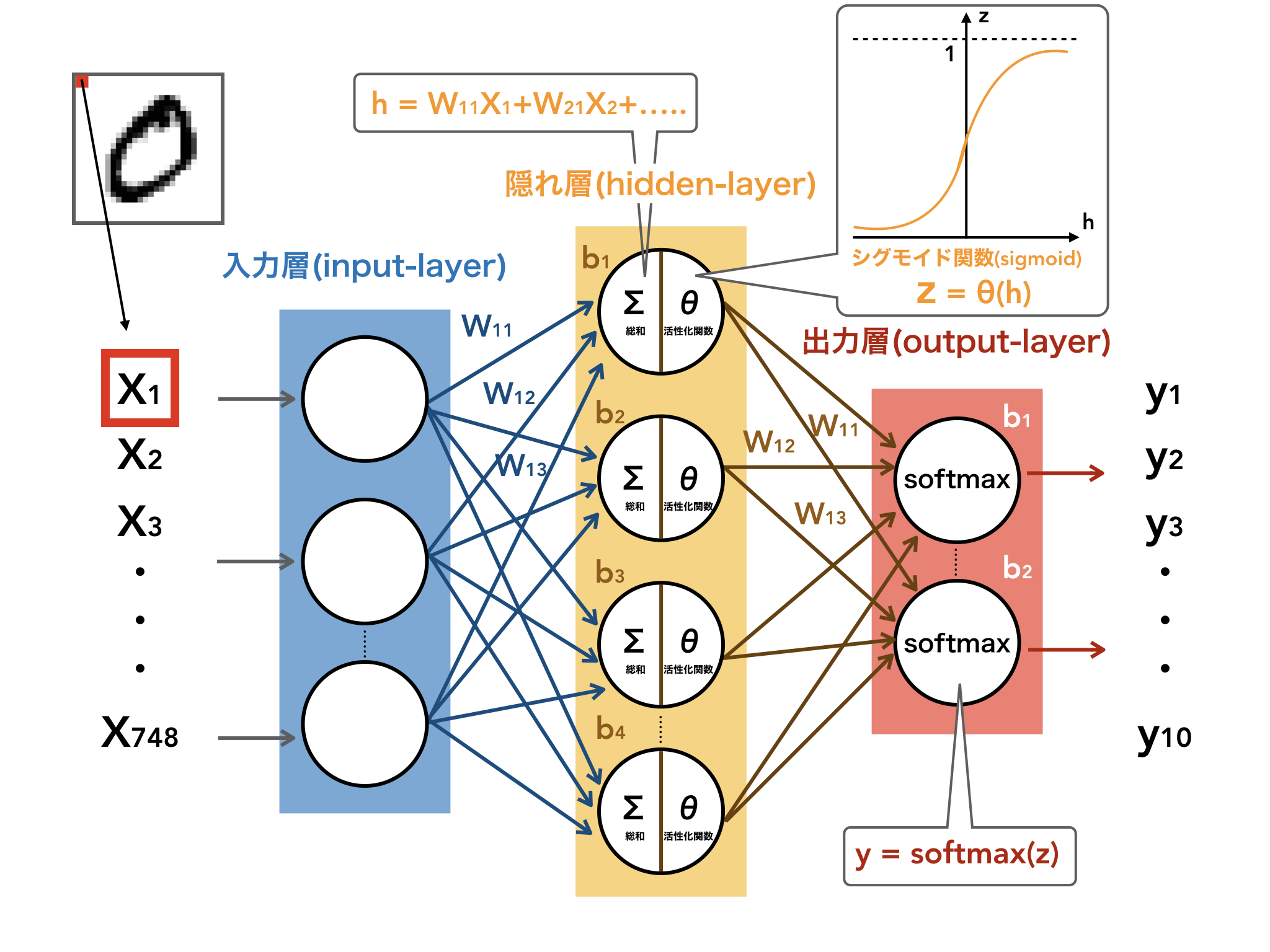

脱初心者!MNIST beginnerに隠れ層を加えたニューラルネット解説 技術ブログ MIYABI Lab

ニューラルネットワークの活性化関数

ニューラルネットワークの基本 ~フィードフォワードネットワーク~ 未来数理合同会社

【pytorch】ニューラルネットでMNISTの分類しながらpytorchの使い方を学ぶ 機械学習と情報技術

【図解】一撃でわかる活性化関数。わかりやすく、そして深く解説。 すえつぐのNLP&LLM

【DeepLearning】Excel VBAでニューラルネットワークを再現|MNIST学習で文字認識 LiCLOG

5分でわかる!ニューラルネットワークの仕組みと実装方法(Python) あぱーブログ

![[活性化関数]ReLU(Rectified Linear Unit)/ランプ関数とは?:AI・機械学習の用語辞典 @IT [活性化関数]ReLU(Rectified Linear Unit)/ランプ関数とは?:AI・機械学習の用語辞典 @IT](https://image.itmedia.co.jp/ait/articles/2003/11/di-01.gif)

[活性化関数]ReLU(Rectified Linear Unit)/ランプ関数とは?:AI・機械学習の用語辞典 @IT

【ディープラーニング入門(第2回)】ニューラルネットワークの活性化関数を理解して実装しよう Qiita

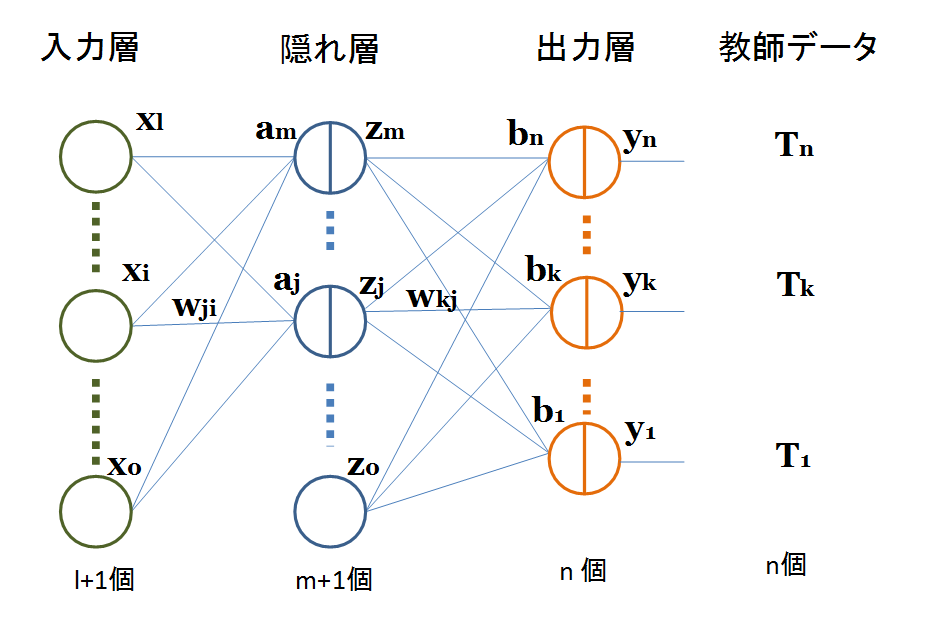

ニューラルネットワークの順伝播,逆伝播,確率的勾配降下法を手計算する

ニューラルネットワークに活性化関数がある理由

ニューラルネットワークの活性化関数の実装まとめ (sigmoid, ReLU, Leaky ReLU, swish, hswish, softmax)|Python Tech

C言語でニューラルネットワークの実装(1)〜多層パーセプトロンの構造と活性化関数〜 初心者 Qiita

【深層学習】ニューラルネットワークの仕組みとディープラーニングモデル性能最適化のポイント解説

31.ニューラルネットワーク(NN,DNN) sLab学習サイト

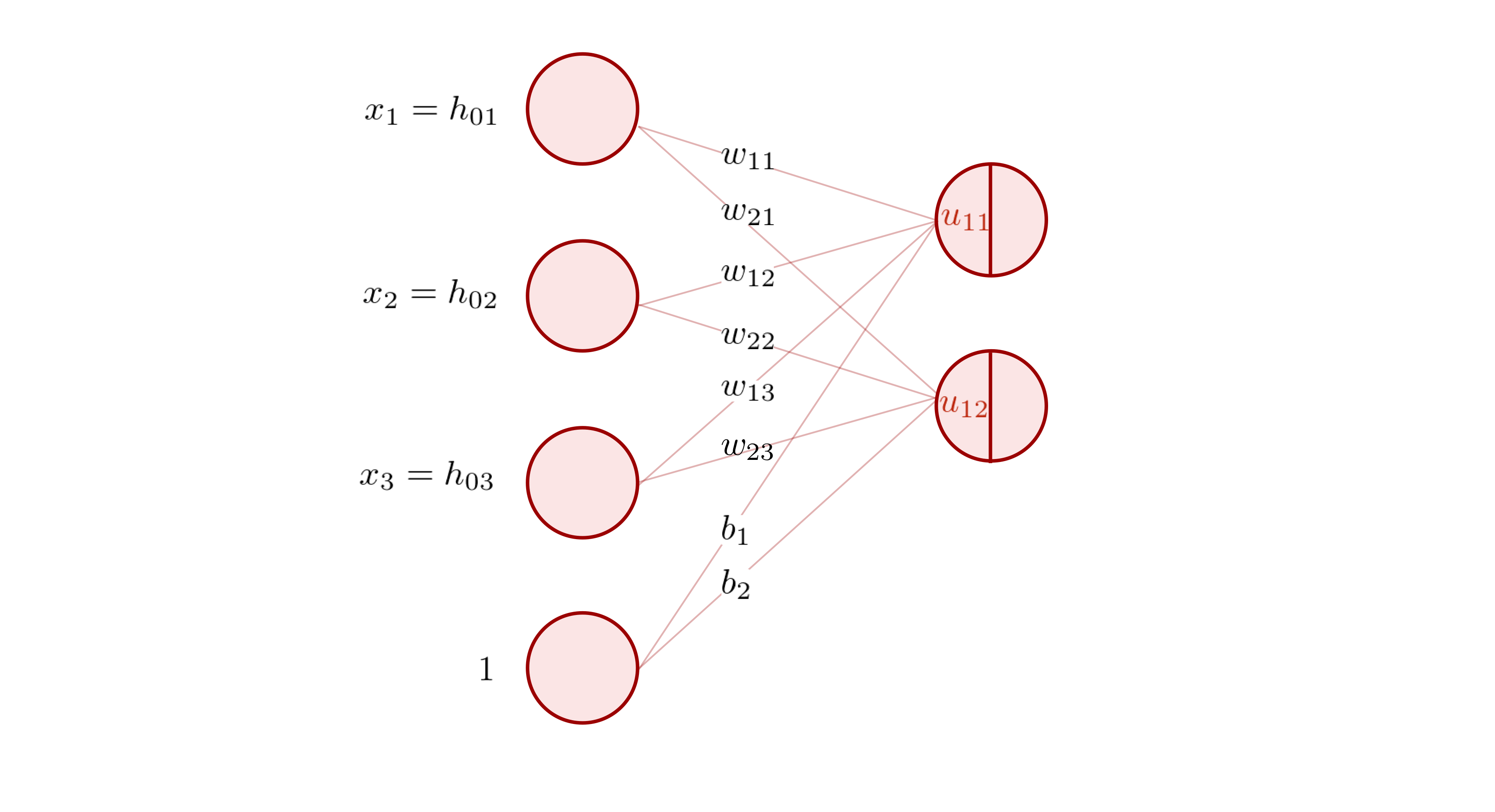

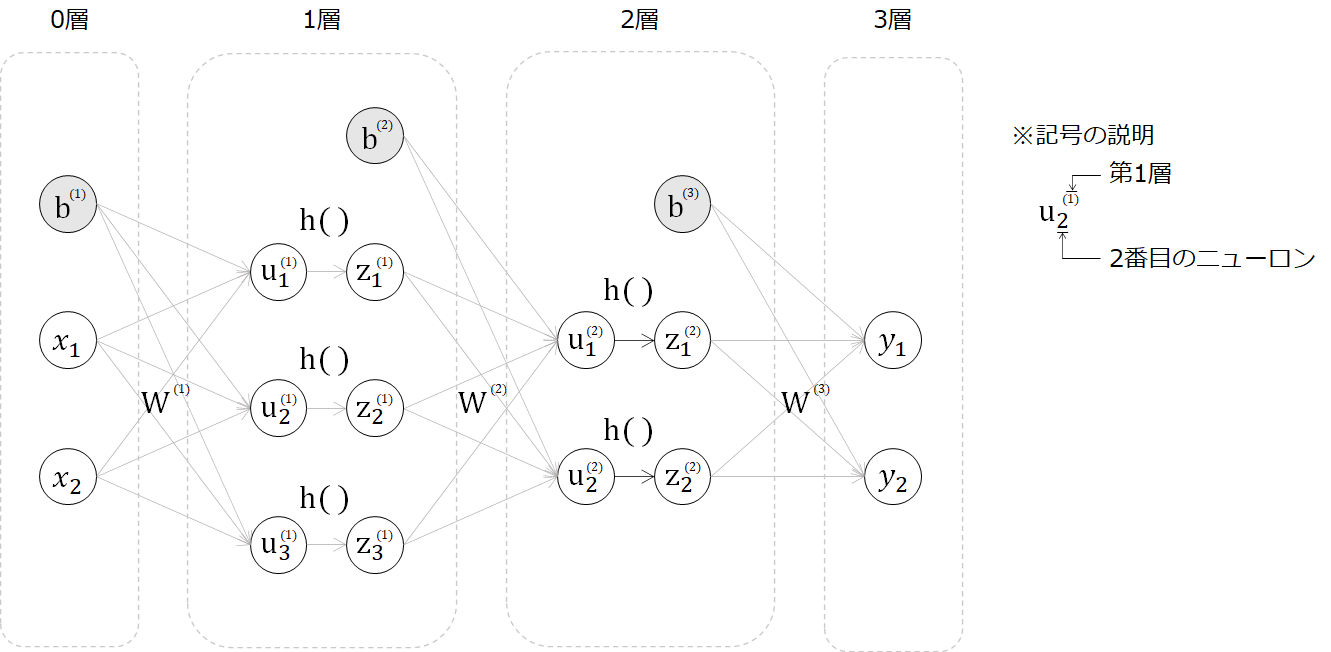

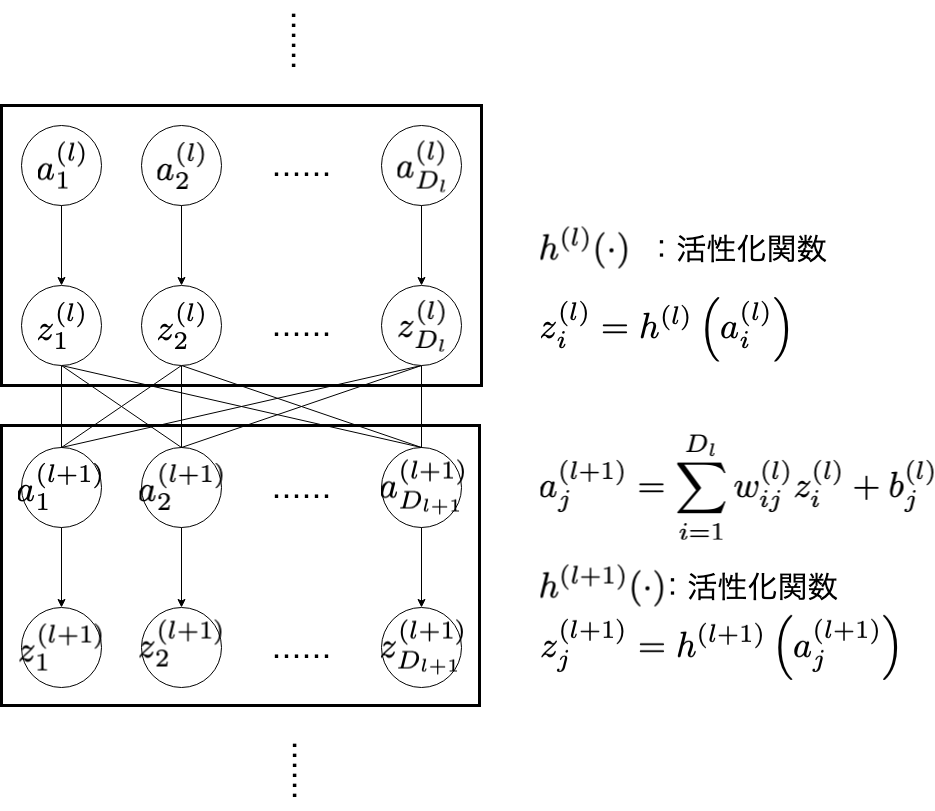

活性化関数とは、ニューラルネットワークに非線形性を持たせることで表現力をupさせるものです。 実際、非線形な活性化関数を用いないと、ニューラルネットワークをいくら深くしても1層のニューラルネットワークと同等の表現力しか持てません。. ここでは、ニューラルネットワークを用いて回帰問題を解く場合について説明を行うため、最終出力層に活性化関数を用いていません(注釈3)。 ここまでで、ニューラルネットワークの順伝播計算の中身について詳しく見てきました。